結局メタバースってなに? ~ Facebook改めMeta社やマイクロソフトは何をしようとしているのか

はじめに

あのテックジャイアントの一角であるFacebook社がMeta社に社名変更を先日のConnectにて発表しました。社名変更自体はInstagramなど参加の企業が増えてきたので階層を整理したい、とか風評的に逆風の真っただ中なので印象を変えたいとか色々あるのだと思いますが、その上でGoolgeのAlphabetのように無難な名前では無く 「Meta」 という社名を付けたことにはメタバースを推進する強いメッセージ性があると思います。また、マイクロソフトもMicrosoft Cloud at Ignite 2021でMesh for Microsoft Teamsなどメタバース事業を改めて強調しました。

さて、この「Metaverse (メタバース)」 とはなんでしょうか? 実は「Metaverse (メタバース)」 という言葉は様々な意味を含み、かつMeta社は結構限定的というか狭義の 「Metaverse (メタバース)」 に関して話ています。なので、結局何するの? VRChatやあるいはFortenaiteみたいなの作るの? セカンドライフ? と言う感じでイマイチイメージと合わない人も多いと思うので、今回はそのあたりを解説したいと思います。

Meta社周りとしてこちらで10分ちょっとの動画で話しているのですが、今回は少しそれを補足する形の記事になります。 www.youtube.com

注意事項

私はMeta社やマイクロソフトの社員ではないので、公式の見解とは一部異なる可能性があります。ご注意ください。

メタバースは既にゲームが実現している? 広義のメタバースと狭義のメタバース

Metaverseとは何でしょうか? まずはWikipediaで確認してみましょう。

メタバース 出典: フリー百科事典『ウィキペディア(Wikipedia)』 ナビゲーションに移動検索に移動 メタバース、メタヴァース (英: Metaverse) は、SF作家・ニール・スティーヴンスンによる1992年の著作『スノウ・クラッシュ』の作中で登場するインターネット上の仮想世界のこと。転じて、将来におけるインターネット環境が到達するであろうコンセプトモデル[要曖昧さ回避]や、仮想空間サービスの通称としても用いられる。メタ (meta-) とユニバース (universe) の合成語。

メタバースに関連した概念として、仮想空間サービス(アバターチャット)・バーチャルリアリティやサイバースペースがある。

引用: https://ja.wikipedia.org/wiki/%E3%83%A1%E3%82%BF%E3%83%90%E3%83%BC%E3%82%B9

元々、SFの作中に登場した言葉で、インターネットや コンピュータの仮想世界的なもの です。攻殻機動隊やマトリックス、楽園追放とかSAOとかSFやアニメでおなじみの電脳世界ですね。転じて、実際の仮想空間サービスの通称として使われます。SF的なイメージだと3Dの印象が強いですが実際のところ2Dでも3Dでも、VRであってもなくても 「アバター」 「オープンワールド」 「ソーシャル」 という3つが合わさると 「メタバースである」 と言われます。なので、有名なメタバースの事例としては結構、ゲームが先行していてどうぶつの森やFF14、そしてゲーム内でコンサートまで開かれているFortnite(フォートナイト)は 「メタバース的」 と良く呼ばれる作品です。他にもRbroxやマインクラフトのようなワールド作成系も多いです。ゲーム以外にも、セカンドライフのようにゲームと言うよりは純粋にメタバース的なものを目指したクラフト系のオープンワールドもあります。

もちろん、VRヘッドセットを付けてバーチャルの世界にどっぷりとつかるVR ChatやバーチャルキャストのようなVR SNSもこうした 「広義のメタバース」 に分類できます。

では、「狭義のメタバース」 とはなにか? 今のところその定義は「おまんなかではな」という感じで固まったものは無い印象ですが、今回はFacebook改めMeta社の説明しているものをベースにします。多くの人が広義のメタバースに対して限定して話す時のニュアンスと近い気がするのと、良くも悪くも大企業として影響を与えると思いますので。

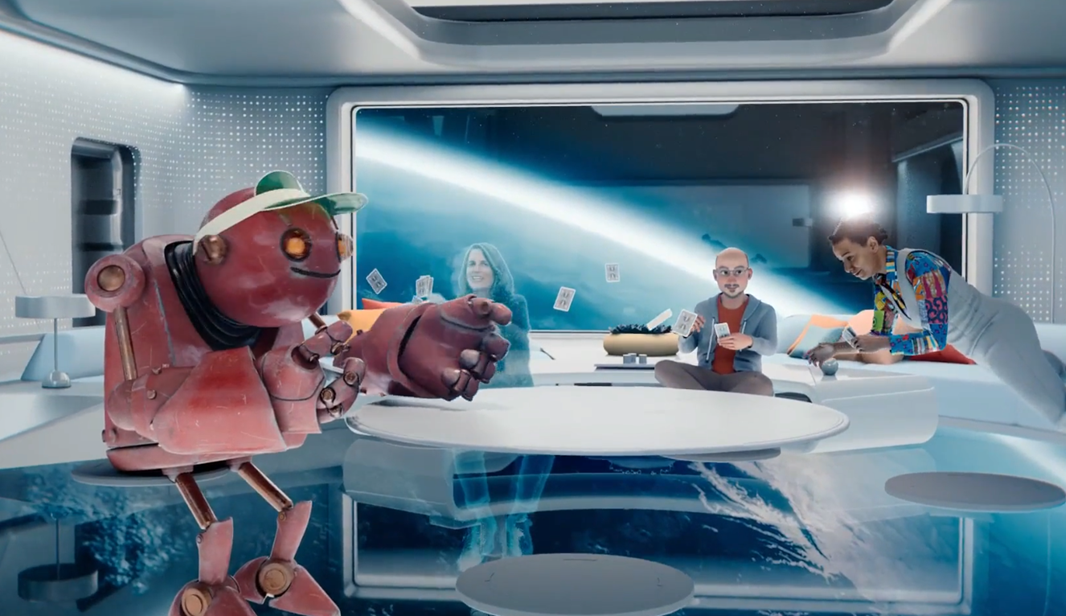

狭義のメタバースはVRやMR/ARを使って単なるディスプレイよりもずっとリッチな体験を提供します。まだ見たこともない世界中のどこにだって行くことが出来るし、異世界にだって行ける。海の底でサメを見たり恐竜に出会ったりも出来ます。VRはSFと違い五感の全てをハックできておらず、視覚と聴覚程度なのですが実際に付けると分かりますがそれでもかなりの没入感があります。良くできたVR世界を歩くのは普通に 「観光として」 楽しいものです。他にも遠隔に居る人が実際に目の前に居るように話たり共同作業が出来ます。まるでテレポーテーションみたいですね!

しかし、これだけでは 「狭義のメタバース」 とは言えません。最も重要な事はそれが オープン であること。単独のクローズドなプラットフォームでは無く、複数の異なるプラットフォーム同士が接続し 相互に運用 出来る事。これこそが 「狭義のメタバース」 の中核です。Meta社の最終ゴールはこちらのメタバースです。Interoperability/(相互運用性) というのは普段使わない言葉なので少し分かりづらいかもしれませんが、同じアバターで複数のゲームやアプリをそのまま利用できる、アイテムなども持って移動できる、ゲームやVR SNS同士が繋がっている、などでしょうか? ソードアートオンラインのザ・シードが一番イメージに近いと思います。

テレポーテーションとInteroperability(相互運用性)

ConnectのキーノートではこのテレポーテーションとInteroperabilityを多用して説明していたと思います。この部分をもう少し深堀しましょう。

Metaverseでのテレポート

物理的な場所に依存せずに同じ場所に

MetaverseではZoomなどのようなテレビ会議よりもずっとリアルに 本人が目の前に居る という体験を提供できます。これはバーチャルな世界にアバターを作るVRでも、リアルな世界にアバターを重ねるAR/MRでも変わりません。また 「単に会って話をする」 というだけでは無く、 ホワイトボード や スポーツで使う道具(ラケットやボール等) も 3Dモデルとしてメタバース上に構築 する事で遥かにインタラクティブなコミュニケーションを行う事が出来ます。これによって現実と同等以上の体験をリモートでも実現できます。特に建築や車などをまず3Dモデルで作ってそれを実際に見る、という方向性は以前より注目されている分野の一つです。

簡単にはいけない場所に

- 宇宙空間や歴史上の世界を実際に体験

- VRの中でしか存在出来ない空間に

VRやAR/MRであれば実際に行けない場所、出会えないものに、に簡単にあったり触れたりする事が出来ます。ゲームの世界だってあり得ない場所ですよね? こういったところに簡単にいくことで、例えば教育面では資料集などの写真を眺めるのではなく実際の土星を近くでみたり, 古代ローマの世界を体験したりと、今までと違った切り口での教育をする事が出来ます。日本だとN高のVR学習がこうした試みですよね。コンサートやスポーツ観戦も今後のキラーコンテンツになっていくと思います。

ref: https://www.youtube.com/watch?v=0H5mb1KEDBw

MetaverseでのInteroperability/相互運用性

ここまで説明したテレポーテーション はとても魅力的な特徴ですが、これはVRやAR/MRが持つ特性でありこれだけでは狭義のメタバースにはなりえません。最も重要なのはオープンであることです。

既に述べた特徴はそれ専用のVRアプリやMRアプリを開発すれば事足りる事ですし、実際多くの企業が開発/提供をしています。別世界を体験できるVRゲームだってたくさんあります。メタバースとして重要なのはこれらが繋がっている事です。例えば、VR ChatからビートセイバーやPOPULATION: ONEにシームレスに移動できたり、バーチャルキャストなど別なVR SNSに行けたり出来る事です。その際に、単なるランチャーでは無く同じアバターで同一人物として行くことが重要です。アイテムだって持ちまわせたりした方が良いですよね。

VR ChatはVR Chatのワールドとして様々なゲームを作り同じアバターで体験できます。バーチャルキャストはVCIという形でアイテムを別なルームやスタジオに持っていくことで、更なるポータビリティを実現していますが、それをVR ChatやClusterに持ち込むことは出来ません。狭義のメタバースで求められるのはそういったプラットフォームをまたいでの相互運用になります。今のところ一番近いのはVRMじゃないでしょうか?

VRMはバーチャルキャスト社が中心になって作っている人型アバターのための標準規格です。国内の多くのゲームやVR SNSがVRMに対応しているため、VRMを介して同じアバターで別なゲームやVR SNSに行く、ということを煩雑ではありますが限定的に実現できています。

バーチャルキャストのThe Seed OnlineやPixivのVRoid Hub、DMMのDMM VR ConnectなどVRMを共有しゲーム内にシームレスに取り込むプラットフォームもあります。残念ながら各社間での連携は実現されていないのですが。。。VRoid HubやDMM VR ConnectはSDKもあるので、こちらを自分のゲームやアプリに組込めば独自でアップローダ的なものを作る必要は無さそうです。この辺がまとまったり、グローバルでも存在感が出ると国内からMetavaseのキーテクノロジーがでるかもしれません。

話を戻しますが、こうした一社のプラットフォームでは実現できない事がメタバースなので「どこかの一社が作る」というのは現実的な話ではありません。Meta社のHorizonシリーズもMetavaseを実現するための重要なキーだと考えていると思いますが、彼れも自分たちだけで出来るものと言ってるわけではないのです。

インターネットがそうであったように、こうした相互運用が可能なAPIや仕様の策定、およびコミュニティの育成がメタバースの実現には不可欠です。

メタバースはディストピアの悪夢? VR vs MR

こんなメタバースですが、ディストピアへの第一歩だと警鐘を鳴らす企業もあります。ポケモンGoでおなじみのNianticです。

曰く、仮想世界にどっぷりつかるのではなく、外を歩き、周囲の人々や世界とつながることを奨励する、とのことです。実はこれと似たような事って良く言われますよね。ゲーム、特に没入性の高いVR SNSなんかだと、現実世界に帰ってこれない&ないがしろにしてしまうんじゃないか、と。 もっと人と会ってリアルなコミュニケーションを大切にしろ 云々かんぬん。仮想世界の自分は 「違う自分」 なのか? とか、そもそも 「ネットだってリアル」 なんだが、とかいろんな議論を巻き起こしそうな話題ですよね。

ことの賛否はさておきとして、Meta社の考えるメタバースは仮想世界に引きこもるものではありません。いくつかの例を示した中にある通りですが、むしろAR/MR的な現実に仮想世界を重ねる試みを中心に考えています。もちろんVRを否定しているわけでは全くないですが、車の両輪でありVRに完全にどっぷりつかる、というよりも現実の延長としてVRが適した場面ではVRを使う、という感じですね。

このようにMeta社のメタバースはVRに限定されていません。むしろ、MSはもちろん、Meta社もMR的なものを強く意識しており、多くのコンセプトデモがMR的なものになっています。彼ら自身はVRデバイスしかまだ販売してないのに。そして、MRとVRを統合することは一つ重要な問題を呼び込みます。アバターが 「仮想世界で全く違う自分を演じる」 というより「仮想世界での自分の装い」 という側面が強くなるという事です。

もちろん彼らはアバターの多様性を否定しません。リアルアバターも良いですし、アニメ調したアバターも問題ありません。ロボットのような全然違う自分になるのもOK。ただ 「別人ではない」 というのがMeta社のスタンスでしょう。本名を使うかとかはさておきとしてMRとVRをシームレスに統合しようとすると現実と仮想世界が別人だと困りますからね。これはそもそもMRの技術から始めているマイクロソフトのMeshもそうですし、警鐘を鳴らしたNianticのLightship もMRだからそうですね。また、あの 人の目レベルの超高解像度 を謳うVarjo(ヴァルヨ)が開発するVarjo Reality Cloudも超リアルアバターを想定しているので、現実を仮想世界に持ち込む想定でしょう。 www.moguravr.com

ロールプレイをあえて否定するわけではないと思いますが、その中心はあくまで現実の自分と仮想世界での装いなのだと思います。現状のVR ChatなどVR SNSはむしろリアルと仮想を切り離す方向が少なくとも日本では主流に見えるので、ここらはメタバースを進めようとしてる企業との大きな歪みになるかもですね。まあ、VR SNSで 「別人」 をしてる人は存外少ないのかもですが。ちょっと見た目の性別が違うだけで。

未だ不明瞭な両者のオープン性

単純に、まだ 「その段階にない」 というだけだと思いますが、現時点ではMeta社のHorizonもMicrosoftのMeshも 「単なるクローズドなプラットフォーム」 の域を超えていません。 次世代のインターネットになるためには 「単なるクローズドなプラットフォーム」 を超えた 「オープンなMetavase」として、すでに述べた相互運用の仕組みを作らなければなりません。

メタバースをインターネット的なものと捉えるなら以下のようなものが必要でしょう。

- デバイス:インターネットのPCに相当。AR/VRのデバイスがより高性能でコンパクト

- API仕様:HTTPやHTMLに相当する仕様。オープンで標準化されている必要がある

- ビューア:HTMLのブラウザに相当するもの

- コンテンツ:APIを使って実装されたコンテンツ

- コミュニティ:利用者と開発者のコミュニティ

デバイス、特にMRデバイスがまだまだ性能不足なのでそこの強化が必須なのは当然として、それ以外の部分は未だ各社の中に閉じてすべてを一体のアプリとして作っている状態です。特性の近いVR SNS同士はさておきとして、ゲームとの相互運用をどうするかは非常に難しいです。各社が適用するAPIの上でゲームを作るのか、それとも橋渡しをするだけのAPIになるのか。アバターも例えばマイクラフトのような世界観にリアルアバターが突然現れるとおかしいので、デフォルメしてコンバートするような機能も必要でしょう。逆もしかりです。まあ、プラットフォーム毎の 「ドレスコード」 を決める事でも解決できるかもしれないですね。こうした、様々な事を行っていく必要がありますが、現時点では標準規格を決める以前に出来る事を増やすってのが各プラットフォームの状況だと思います。

どこまでオープンなのか? という課題もあります。アダルトコンテンツやアングラも含めたインターネットのような真にフラットなプラットフォームの上に各社の仕組みを作るのが理想的には思えます。しかしながら、今更フェイクニュースやスパムのあふれる世界を新規に構築したいでしょうか? ある程度のプライバシーやセキュリティは現代なら基盤自体に組込んでおきたくなる気がします。そうすると、ゆるやかな集権としてかつてのパソコン通信のようにプラットフォーム間での接続方式が取られるのではないかと妄想しています。つまりMeshとHorizonとVarjo Reality CloudとLightshipが相互接続されて、シームレスに行き来が出来るということですね。当然、アバターやアイテムも持ち越さないといけないので、その仕様を標準化する必要はあるのだと思います。まあ異なるゲーム間の接続とかVR SNSとゲームの接続に比べれば比較的マシな作業かもしれません。TSOやVRoidHubが天下を取ると面白いのですが...

いずれにしても膨大な作業なので、正直Metavaseというのはあと数年で実現するような近いゴールではありません。10年、20年で考えるような事へのチャレンジだと思っています。もちろん、過程の段階でも段階的に便利になっていくわけですが。

まとめ

FacebookがMeta社になりメタバースの推進を改めて宣言したり、それに便乗?する形で元々作っていたマイクロソフトもMeshをアピールしたりと、Metavaseの実現へ大資本が動きだし世間の目も変わってくるのではないかと思います。個人的には非常にワクワクする流れですが、メタバースという言葉の意味は広いのでMeta社や多くのXRリーディング企業の考えるMetavaseに関して自分の理解でまとめてみました。特にVRとして独立した仮想空間を作るというよりもVRかAR/MRかに関わらず、現実の拡張としてのメタバースを指向されているというのは大きなトレンドだと思います。この数年でいきなり完成するものではないですが、今後どうなっていくかとても楽しみですね!

また、この記事はMeta社の発表をベースに彼らが目指しているオープンな狭義のメタバースの話をしていますがそうじゃないものに価値が無い と言う話では無いのでよろしくお願いいたします。

それでは、Happy Hacking!

Slide4VRアップデート 2021/07/06

Vキャスでのプレゼン支援サービスのSlide4VRをアップデートしました. slide4vr.nklab.dev

というか、アップデート自体はちょこちょこずっとやってきてたのですが、今回バックエンド側を結構弄ったのと過去の改修も含めてまとめて書いておこうかと。

アップデート

VCJE対応

亞希乃さんと一緒にVCJEへの対応をしました。これによりSlide4VRのサイトにアクセスしたり、config.jsonをエディタで貼り付ける作業が要りません。超絶便利!! 亞希乃さん、ありがとうございます。

合わせてトークン対応したり外部のアプリから連携できるように改修しています。もし自分のアプリから連携させたいという方がいらっしゃいましたらTwitterなどでお声がけください。

個別スライドのOGP対応 (実験)

まだ実験段階ですが個別スライドのOGP対応を行いました。これで下記のようにブログに埋め込んだりツイートした時にもスライドが表示されます。ただし、変換まではスライドが表示されるようになってから数十秒程度かかるのでアップロードして画像に変換した直後のスライドはOGP対応されてないので注意。

SSG対応が必要だったので副産物として個別ページが静的ファイルになっています。ピュアなVue.jsからNuxt.jsに切り替えたりと想定よりだいぶ難産な改修だった。。。

サービスメッシュ/Workflow周りの改修及びパフォーマンスの改善

これは完全にバックエンド側の話で利用側からは見えない部分ですが、Slide4VRは内部的にはマイクロサービスになっています。このサービス間の接続およびワークフローエンジンとしてkuda-proxyという独自のサービスメッシュを使っていたのですが、GCPが正式にCloud Runへのワークフローに対応したのでそちらの機能を利用するように作り直しました。合わせてデバッグしやすいようにシステム構成もいくつか変更しています。VCJE対応の時にデバッグがしづらい部分が浮き彫りになったので、その辺に対応できるようにサービス間の通信のログを出力できるようにしたり、テスト用のAPIに切り替えやすくしたりですね。

また、元々Javaで実装していてCloud Runの謎の制約により各サービスの起動が10秒程度かかりトータルで3数十秒かかるという状態だったので、VCJE対応のタイミングでGraalVMのnative-imageに変更しました。これで1秒以下の時間で起動するので快適になったのですが、反面ビルドが10分近くかかるように。。。 という分けで、kuda-proxyをGoでGCPのワークフロー対応と合わせて書き直しています。ビルドも実行も速くなって快適。また、APIの認証周りを強化したので一応セキュリティが上がっています。特にパブリックから操作されてまずいものは元からないのだけど。

今後の対応予定

スライドの公開機能など基本機能の拡充

現状ではスライドはリンクを知らないと見れない、という状態なのでSlideShareやドクセルみたいに公開設定にしたスライドが普通に見えるようにはしたいと思います。あと、地味に編集機能が今ないのでそれも作らないとなぁ。。。

UIも色々バグっぽい動きしてるところがあるので、その辺の改善もですね。

VCIジェネレータ対応 & 強化

Roomとかにも対応できるようにプレゼン用VCIをPDFから直接生成する機能を下記に作ってるのですが、こちらをSlide4VR側に取り込みたいですね。 また、生成するスライドVCI自体もリモコンに対応したりといくつか改修を入れていけたらと思います。TSOへの自動アップロードはAPI待ち! vci-slide-generator-dnb6froqha-uc.a.run.app

個別スライドのOGP対応

パフォーマンスの劇的な改善はちょっと難しいのですが、アップデートされたことが分かりやすくなるようにとかUI的な改善は入れたいかと思います。

まとめ

ここのところずっと裏側の仕組みのところをずっと弄ってました。UIはほぼ変わってないのですが裏側は結構変わってたりはします。これでだいぶ色んな改修がしやすくなったので、もうちょっと使いやすいようにUIも改善していきたいですねー。 今後は改修したらもうちょっと頻繁にアップデート情報を書いていきたいですね。

それではHappy Hacking!

テックポエム:019 - Apple Glassを待てない! 2021年のAR/MR Glass 6選

- はじめに

- AR/MRグラスって? スマートグラスとは違うの?

- MAD Gaze – Glow Plus

- Nreal Light

- ThinkReality A3

- Kura Gallium

- Vuzix’s Next Gen Smart Glasses

- Qualcomm's blueprint

- まとめ

はじめに

Google Glassから始まるスマートグラス/ARグラスですが2021年現在は結構良いものが出始めてきたと思っています。去年も2020年のスマートグラスという形で記事を書いたのですが、あれから1年で変わったこともありますし、2021年版を書きたいと思います。

こちら動画も作成しましたが本記事は動画の補完になるので良ければ動画の方も是非見てみてください。

配信に使ってるスライドはこちらです。

AR/MRグラスって? スマートグラスとは違うの?

スマートグラスなら聞いたことがあるけれど、AR/MRグラスってなんだろう? という方も居ると思います。端的に言えば「みんなが想像しているスマートグラス」はAR/MRグラスだと思って良い気がします。

電脳コイルとかSAOのオーグマーとかですね。仮想オブジェクトに触れたり、現実世界にテクスチャを重ねるのがAR/MRグラスになります。逆にいえばメガネ型デバイスであっても単に映像を映すだけであったりするのはスマートグラスとして分類されます。また賢い眼鏡は全てスマートグラスなのでAmazonのEcho GlassやBoseのBose Frames のように映像ではなく音声を取り扱うものもスマートグラスとして分類されます。これはこれでウェアラブルガジェットとしては面白いものですが、ちょっと自分がスマートグラスという名前で期待してるものとは違います。なので耳馴染みは悪いのですがAR/MRグラスという言葉を使うのが良いと思います。

では、AR (Augmented reality/拡張現実)とMR (Mixed Reality/複合現実)の違いは何でしょうか? リンク先にある通り定義としては異なるものですが製品のマーケティング用語として使われる側面もありますし、そこまで区別する意味はないと思っているので今回は同じものとして扱います。

MAD Gaze – Glow Plus

Glow Plusは中国のMAD Gazeにより販売されているAR/MRグラスです。ぱっと見単純なサングラスに見えるデザインですが、すでに販売されておりAmazonで購入することもできます。

USB-C DisplayPort (DP Alt Mode)を使ってスマートフォンやPCと接続することが可能です。PCやスマートフォンとミラーモードで繋いだ時にはサブディスプレイとして使えるのでスマホのゲームやYoutubeなどを大画面で楽しんだりすることもできます。旅行に最適ですね。

一方で、AR関連の機能は粗削りな部分が多くアプリも不安定なのでARの完成品を楽しみたいという人には物足りないと思います。

Nreal Light

NReal Lightは中国のNrealにより販売されているAR/MRグラスです。こちらはauとも提携して去年末から日本で販売しています。auのオンラインショップで購入することも可能です。

CESでもその性能の高さが有名でカタログスペック上はGlow Plusとも似てますがその完成度は大きく異なると言われています。またauと提携しているので日本のコンテンツもソフトウェアとして提供されています。一部のauでは店舗デモもしているらしいので機会があればぜひ試してみましょう。

ThinkReality A3

ThinkReality A3はベンチャー企業ではなくThinkpadで有名なLenovoによって2021年中ごろに販売予定のAR/MRグラスとなります。

他のデバイスとはことなりエンターテイメントではなく、法人向けに特化しており工場や機器調査などのさいに利用したり、PCと接続してマルチディスプレイとして使うことが想定されています。

WFHということで自宅からリモートワークをする人も増えたと思いますが、スペースの都合でマルチディスプレイを十分に揃えれてない方も居ると思います。私とか。ThinkReality A3を使う事で5枚のディスプレイを空中に浮かべる事が出来き他のデバイス以上にユースケースがしっかりしているので購入を検討しやすいデバイスかと思います。

Kura Gallium

Kura Galliumはアメリカのベンチャー企業のKuraによるデバイスです。2021年末から2021年初頭にかけて発売とアナウンスがされています。

特筆するべきは8Kで視野角が150°という圧倒的な性能の高さです。他のデバイスとは隔絶した性能になっています。それでいて、コンパクトかつ見た目もすっきりしているという事で、スペック通り発売されれば間違いなく最強のデバイスとなるでしょう。

Foveated Rendering(フォービエイテッドレンダリング)という技術が採用されており、これは目の届きにくい視界の外側の解像度を落とすことで接続するスマートフォンの負荷を軽減する技術です。

Vuzix’s Next Gen Smart Glasses

Vuzix’s Next Gen Smart GlassesはAR/MRグラスの老舗であるVuzixによって開発されるデバイスです。発売日は未定。 こちらはCES2021で登場して大きな話題になりましたが、micro-LEDの採用により非常に薄くほぼ完全に通常のメガネと同様の見た目をしているのが最大の特徴です。

どちらかというとスマートグラスよりの位置づけになりそうではありますが、このコンパクトさが実現されればスタンダードデザインとして他社も追従してくると思います。

また、大きな特徴としてVuzixはすでに10年以上のARグラスの開発/販売の実績があります。そのため顧客をすでにある程度掴んでおり、その点がこれから開拓をするのみの他のAR/MRグラスとは大きな違いです。

Qualcomm's blueprint

Qualcomm's blueprintは実際の販売予定のデバイスではなく、XRデバイスに多く使用されるSoCのSnapdragonを開発するQualcommによるリファレンス実装です。正確にはXR1 Smart Viewer reference designとなります。先ほどの紹介したLenovoのThinkReality A3はこちらをベースにしていると言われています。

Quest2を筆頭に多くのスタンドアローンVR HMDに使われているXR2の一つ前の世代のチップですが、接続するスマートフォンとリソースを分配する事が出来多くの処理をスマホで実施することが期待できます。また6DoFやハンドトラッキングなども搭載しており、今後こちらのハイスペックなリファレンスをベースとしたさまざまなデバイスが出てくることが期待されます。

まとめ

毎年出る出る詐欺というかみんなの期待が集まっているApple Glassですが、現状紹介したものをUXとして越えなければいけないのでもう少し温存してから出す気が個人的にはしています。それよりも、今ある、あるいは直近で発売するデバイスで良いものがどんどん出てきているのでそっちをしっかり楽しめればと思って動画の作成や記事の作成をしました。特にWFHにすぐにでも使いたいThinkReality A3が今年の中ごろには出るという事で、とても楽しみです。 とはいえ今年のWWDCでApple Glassが出ると非常に嬉しいので楽しみですけどね。

それではHappy Hacking!

【Vキャス用】Unity無しでWebからVRスライドが作れるVCIスライドジェネレータを作ってみた

はじめに

バーチャルキャストではVCIというアイテムを使う事で様々なインタラクションが出来ます。 これはメチャクチャ便利なんですが、当たり前の話として3DのアイテムなのでUnityが必要。でも、スライドVCIや音楽プレイヤー、あるいはホロポスターや電子書籍みたいなのは コンテンツの中身だけ差し替えれれば良い ので、もっと手 軽にパッケージング できれば絵師さんとかコンテンツクリエイターの人に使いやすいのに、と思って UnityなしでWebサイトにアップするだけでVCIに変換できるデモサイト を作ってみました。ちなみに将来的にはSlide4VRの方に組込む予定です。

解説動画で使い方やモチベーションに関しての動画も作りました(Youtube版, ニコニコ版)。 使用しているスライドはこちら。

【Vキャス用】UnityなしでVRスライドが作れるVCIスライドジェネレータを解説

使い方

使い方はとても簡単で以下の3工程だけ!

- パワポやGoogle Slideでプレゼン用のPDFを作ります。16:9に最適化されてます。

- デモサイト にアクセスしてPDFをアップロード

- ダウンロードしたVCIをThe Seed Onlineにアップロード。これだけです!

ちなみにできたもののサンプルがこちらとなります。

なお、元になってるテンプレートは私の「はじめてのVCI」なので、クオリティは今三つくらいですw 誰か良い感じのをお願いします!

なんでこんなの作ったの?

UnityなしでVCIが作りたいから!

です。

もうちょっとちゃんと解説すると、冒頭にも書いた通りコンテンツ系のVCIはリソース差し替えで原則量産できるはずなので、パッケージのためだけにUnity必要なのはなんだかなー、と思ってました。 コンテンツホルダーの方がもっと気軽にVR上にコンテンツを出せれば良いのに、と。その時に、たとえどんなに簡単でもいきなり 「ではUnityをインストールしてVCIプラグインを入れてください」 から始まりますし、パソコン得意な人でも3D触ったことなければそれだけで少なくとも1日はつぶれちゃいます。

というわけで、ハードルが高いのでもっとUnity無しで簡単にしたいというのがモチベーション。

同じようなことを考えられてる人はもちろん他にもいて、ねこますさんなんて2019年から同じようなコンセプトのものを作られてます。

スライドに関しても120byteさんがすでに。 booth.pm

他にもおぐらさんが「VCI「本」作成キット」をUnity Packageで作られています。

他にも探せばもっとあると思います。どれも超素晴らしいツールなので私なんもしなくて良いかな? とも思ったのですが、Unity Packageはもちろんデスクトップ版もUnityベースにしてる都合上デスクトップにアプリをインストールする必要があるので、Webならインストールも不要になるし、もっと簡単に出来るんじゃないかな? という気持ちで比較的得意なWebアプリとして今回作ってみました。C#以外の言語でVCIを読み書きする参考にもなりますしね。

技術的な解説

基本的な発想としてはテンプレートになるVCIをRubyで解析して、画像などのリソースになる部分だけを差し替えています。テンプレートになるVCI自体はUnityで作ってますね。理論的には完全に独自で作ることも可能なんですが、3Dモデルを弄る部分はUnityで作るのが無難でしょう。エディタ自体作りたいなら別ですけれど。

今回はRubyで書いていますが、単なるシンプルなバイナリ操作なのでJSでもJavaでもC#でも問題なく対応できると思います。

元になるVCIを変更すれば音楽プレイヤーとかホロポスターとか自在に作れるはずです。たぶん。

ソースコードは以下に置いてあります。 github.com

また、VCIのフォーマットなどより詳細な情報はこちらをどうぞ。

VCIはVRMと違ってあくまでVキャスの仕様なので、フォーマットとかの仕様書は特に公開されて無さそうなのですがglTFなのでバイナリ解析自体は一般的な方法で出来ますね。あとは雰囲気でリバースエンジニアリング!

今後の予定

今後の予定としては 「はじめてのVCI」 がテンプレートなので、さすがにもうちょっと機能強化はしたいと思います。リモコンとか欲しいし。 その上で、Slide4VRへの取り込みですね。その他にもMusic Playerとかは作ってみたいです。レコードを切り替えると別な曲が再生できるようなの。ホロポスターもチャレンジしたいのですがあんなVCIを劣化版ですら書ける気がしない。。。

ちなみにソースコードはMIT Licenseなので、気兼ねなくコピッて 「お前のダサいVCIじゃなくてもっと良い感じの のVCIやサービスを作ってやんよ!」 というのをお待ちしております。VCI書けるけど、Webは分からんという人は私にVCI連携いただければなんとかしますー。一番良いのを頼む!

まとめ

というわけで、WebからVRスライドが作れるVCIジェネレータの紹介でした。

VCIはユーザストアで有料販売もできますし、VRSNSでの即売会も一般的になってきました。今後、VキャスもRoomでセレクトショップを作る人が現れたり、もっともっと発展すると思います。そんな時に、コンテンツクリエイターの方々が手軽にパッケージングして販売できるようになれば、VRに物凄い興味がある方じゃなくてもカスタマーチャネルの一つとして当たり前に扱ってもらえる時代を期待しています。電子書籍書いたからKindleとKoboとBookwalkerに出版したし、ついでにVキャスも出すか、くらいのノリで。

みんなでバーチャルキャストを盛り上げていきましょう!

それではHappy Hacking!

【メモ】各種クラウドのざっくりサーバコスト比較用

Azureのインスタンス名が覚えられないのでメモ。 精緻な値は見積ツールで見るとしてコスト感を抑える用。インスタンス特性は各ベンダーで微妙に違うだろうけど、比較できるように独断と偏見でマッピング。 Azureは組み合わせパターン毎に名前が付いてるから覚えれば楽そうだがツラい。。。あとコストシミュレータが使いづらい><

GPUとかHPCとか自分が普段使わないのは特になし。割引とかで実際はもっと安くなる気がする。

GCP

GCPは継続利用割引で自動的に20%引きになるのでコストシミュレーションでも適用されてるかも。

エントリ レベルの VM (開発/テスト)

- small, micro など。e2-micro

- $ 6.03/month. 7,500円/year

経済的なバースト対応 VM (小規模システム汎用/VDIインスタンス)

- E2シリーズ 。e2-standard-2

- $ 48.25/month. 6万円/year, 30万円/5年

汎用 VM (小規模システム汎用/VDIインスタンス)

- N2シリーズ 。n2-standard-4

- $ 112.30/month. 14万円/year. 70万円/5年

コンピューティング最適化

- C2シリーズ 。 c2-standard-4

- $ 120.68/month. 15万円/year. 75万円/5年

メモリ最適化

- M1,M2シリーズ 。 m1-ultramem-40 (CPU:40, RAM:961GB)

- $ 3,190.60/month. 400万円/year. 2000万円/5年

Azure

年間契約でだいたい4-6割程度値下がり。

エントリ レベルの VM (開発/テスト)

- Aシリーズ など。A0.

- $ 14.609/month. 2万円/year

経済的なバースト対応 VM (小規模システム汎用/VDIインスタンス)

- BSシリーズ 。B2MS

- $ 72.47/month. 9万円/year, 45万円/5年

汎用 VM (小規模システム汎用/VDIインスタンス)

- Dシリーズ 。D4 v3. DSシリーズはPremiumストレージが利用可能. SSDならこっち。基本的に新しい方が安いので必ず新しいバージョンを選ぶ。

- $ 163.52/month. 20万円/year. 100万円/5年

コンピューティング最適化

- Fシリーズ。F4s v2

- $ 154.76/month. 20万円/year. 100万円/5年

メモリ最適化

- Mシリーズ、Gシリーズ 。 Msv2 (CPU:32, RAM:875 GB)

- $ 23,099.39/month. 3000万円/year. 15,000万円/5年

参照

【バズワードを学ぶ】SMBCのコード流出とGitHubの利用を考える

先週話題になった「SMBCのコード流出」とそれに伴う「GitHubの利用問題」です。今回の件に限って言えばGithubはほぼ関係ない業務委託先からの情報流出ですが「GitHubが禁止にされるのではないか?」という話題もネット上ではされていたので、その是非というか有効性に関しても解説してみました。

大筋はZennに書いた内容をエッセンスだけサマった感じですが、はてぶのコメントとか眺めながら少し整えた感じです。 zenn.dev

動画のサマリとしてはこんな感じ。

- 今回の件はGitHubの公開/非公開とかオンプレかクラウドか?とかでは無く内部犯による情報漏洩の問題

- GitHub禁止はあまり解決にならない

- この件に限れば発注元が悪い(と世間からは言われる)

- GitHubのPushを制限しうっかり事故を減らす効果あり

- ただし、悪意のある漏洩には効果が無い

- リスク分類とそれに見合ったセキュリティの適用

まず前提として今回の事件自体は委託先でのやらかしなので、セキュリティ的にはサプライチェーン管理の問題。ちゃんとベンダーマネージメントをしましょう、になります。

その上で、では自社で同じような流出が起きないようにどうするか? を解説しています。ブラックリストのWebフィルタリングやオンプレミスでの運用も含めてやはり内部犯による情報漏洩を防ごうと思うと、透過的ファイル暗号やホワイトリスト運用、厳格なアクセス管理の組み合わせにならざる得ないのですよね。それ以外は 「うっかりミス防止にとどまるというか」

なので、システムで完全な対策を目指すのではなく、情報資産の重要性を判断してその上で適切な仕組みを選ぶ必要があります。99%のコードは(流出ではなく)ソースコード公開してもビジネスインパクトが無いものでしょうから、そういったものをホワイトリストレベルで過剰に守って生産性を下げるのは多くの企業にとって適切ではないでしょう。その代わり1%のコードを持ってるなら、そこは適切に手間とコストをかけて守る必要はあります。

というあたりを24分くらいでまとめてしゃべってるので気になる人はぜひ動画をチェック! それでは Happy Hacking!

【バズワードを学ぶ】PPAPが全面禁止??? PPAPの問題点と代替案に関してまとめてみた

「PPAPが全面禁止」ということで、Twitterのトレンドにも入りましたね。ピコ太郎さんには悪いけど、キャッチーな名前のおかげでかなり話題にしやすくなったと思います。

以前もZennの方でまとめていたのですが、ちょうどバズってたのでいつか作ろうと思ってたPPAP動画を作ってみました。 zenn.dev

動画のサマリとしてはこんな感じ。

- ピコ太郎は悪くない

- PPAPとはパスワード付きZipをメールで送り別メールでパスワードを追加で送る手法

- セキュリティの効果が低いだけでは無く近年ではむしろ有害としてアメリカ政府や霞が関で非推奨に

- 今回、日立が全面禁止したことでトレンド入り

- 代替案としてはファイル共有サービスが一般的

特に、重要な点は現代ではメールであってもファイル暗号は必須ではないことですね。バケツリレーをしていたのは今は昔で現在はMXレコードを参照して相手先を直接指定するので基本的には中継サーバを介さないようです。

このあたり実は自分も良く分かってなかったので、今回調べて知れて良かったです。

バケツリレーがないからファイル暗号であるパスワード付きZipやS/MIMEを使わなくても経路暗号でセキュリティが担保出来るわけですね。

動画中では言及しませんでしたが、今では自前でメールサーバをコーポレートメールとして運用してるところは少なく、多くはマイクロソフトやGMailをカスタムドメインで利用してると思うので、経路暗号を期待して特に気にせず添付ファイルをするというのもそこまで悪手とは思わないのが正直なところです。

S/MIMEの運用が仮に手軽に出来たとしてもS/MIMEは基本的にファイル暗号なのでやはりメールセキュリティが適用できず下記のパスワード付きZipと同じ問題が発生してしまいます。

そういったことを加味するとやはりオンラインストレージ、特にOutlookならOneDrive、Gmail(Google Workspace)ならGoogle Driveとすることでセキュリティ的にも運用性的にもかなり使いやすくなる気がします。 PCIDSSやHIPPAなど高いセキュリティが求められる認証も取ってるケースがあるので、そういった規制される業界にも適用できるのはうれしいですね。

オンラインストレージはセキュリティ的にDLPやきめ細やかなACL、監査ログ、ウイルススキャン、自動バックアップなど様々な機能を持っているので、これらをPay as Goで使えるのはかなり魅力的ですよね。ファイルサーバを運用するとパッチ当てとか気になりますし。。。

それでは Happy Hacking!